Dans le jargon, on parle de “test d’utilisabilité” 🤓 — car non, ce n’est pas l’utilisateur ou l’utilisatrice que l’on teste, mais notre solution !

Beaucoup d’articles existent déjà sur le sujet des tests ; je l’aborde donc aujourd’hui d’un point de vue très pragmatique pour donner un maximum de billes et de retours d’expérience personnelle aux personnes qui me liront et souhaitent se lancer. 🔧

À quel moment du projet organiser un test utilisateurs ?

Le test utilisateurs, qui est probablement la technique de recherche utilisateur la plus répandue, concerne les projets dont la “solution” est déjà a minima matérialisée par un support, sous la forme de zonings ou de wireframes, ou encore, si la solution a dépassé le stade d’esquisse, sous la forme de maquettes graphiques ou de prototype statique, interactif, qu’il soit “jetable” ou itératif. L’objectif global du test d’utilisabilité est alors de mesurer la facilité d’utilisation de ce support. 💯

Le test utilisateurs s’applique donc d’après moi à un moment-clé du projet : celui où un support concret peut commencer à être vu/utilisé. 🚀 Si votre projet n’en est pas à ce stade, il existe beaucoup d’autres méthodes de recherche utilisateur qui s’appliquent avant l’implémentation d’une solution, par exemple l’entretien individuel, le focus group, le sondage, le shadowing…

Combien de testeurs faut-il pour qu’un test utilisateurs soit fiable ?

On aurait tendance à penser que rencontrer le plus de personnes possible pour les mettre en contact avec son produit donnera les meilleurs feedbacks sur ce qui fonctionne bien et ce qui fonctionne moins…

En réalité, il faut savoir qu’un test utilisateurs prend beaucoup de temps à planifier, à animer et à analyser. Alors organiser des dizaines de tests utilisateurs si on ne peut pas allouer du temps à l’étude de leurs résultats est contre-productif ! 🙅 ️Sinon, pour obtenir des retours quantitatifs, beaucoup d’autres méthodes de recherche utilisateur existent, comme les sondages évoqués plus haut.

Par ailleurs, au bout de plusieurs tests utilisateurs, vous remarquerez qu’on commence à récolter les mêmes retours… 😱 En gros, plus on fait de tests, moins on a de chance de découvrir de nouveaux retours. C’est logique, finalement. Il se dit qu’un échantillon de 5 testeurs représente une taille optimale : avec eux, on récolte 90% des retours les plus importants, et on ne passe pas un temps fou à décortiquer les résultats. 🔥

Et une fois les retours des 5 testeurs traités et votre solution optimisée, vous pouvez (devez ?) itérer !

Vous n’avez pas 5 testeurs sous la main ? Dites-vous qu’1 testeur vaut toujours mieux que 0 ! 👍 Jakob Nielsen dit d’ailleurs à ce sujet :

Zero users give zero insights — Nielsen

The most striking truth of the curve is that zero users give zero insights. As soon as you collect data from a single test user, (…) you have already learned almost a third of all there is to know about the usability of the design. 💪 The difference between zero and even a little bit of data is astounding.

Enfin, plutôt que se demander combien de testeurs recruter, je pense que l’énergie à déployer est surtout sur la fiabilité du panel : vos testeurs sont-ils représentatifs de votre cible d’utilisateurs ? 🤔

Comment recruter des participants pour un test utilisateurs ?

Vous avez sûrement entendu parler des sociétés qui recrutent des utilisateurs à votre place. Cela doit probablement être très confortable mais c’est également onéreux. 💵 Il s’agit de payer une certaine somme pour chaque utilisateur recruté par cet organisme spécialisé. Personnellement, je ne suis encore jamais passée par ce type de service. N’hésitez pas à commenter pour partager votre expérience à ce sujet.

Lorsqu’on est en “mode startup”, il faut faire vite et surtout faire économique. Ce que je vous conseille est de puiser dans votre propre réseau de connaissances 👋 et de prendre contact avec :

- Un·e collègue qui n’a pas du tout participé à l’élaboration de ce produit en particulier

- Les membres de votre famille

- Vos ami·e·s

- Toute connaissance dont le profil correspondrait à votre cible

En tant qu’entreprise, vous avez également certainement une mine d’or à disposition : votre présence sur les réseaux sociaux. 🌎 N’hésitez pas à faire appel à votre “communauté” sur Facebook, Twitter, LinkedIn ou Instagram ! Elle répondra certainement présente pour vous aider : par conviction, par sympathie ou même par simple curiosité. ☝️

Chez Poool, j’ai brandé cette expérience de test en créant le “Groupe des Testeurs Poool”. J’invite les volontaires à l’intégrer en remplissant un formulaire. Chaque nouveau·elle volontaire reçoit un email de bienvenue et de remerciement️ qui le·a prévient que l’on fera appel à lui·elle lorsqu’un test sera organisé si son profil correspond à ceux que l’on recherche. ✉️ Et ça marche !

N’oubliez pas que le RGPD s’applique à toute information personnelle que vous collecterez et stockerez à propos de vos testeurs… ☑️ Le recueil de leur consentement, préalablement au traitement de ces données, est donc indispensable. Pour cela, j’utilise une question de type “Legal” sur Typeform.

Si vous devez recruter dans le dur, sans passer par votre réseau, vous pouvez aussi passer au “guerrilla testing” également appelé “hallway testing”. Le principe : faire tester sa solution à des personnes croisées et interpelées dans la rue. 🏢 Selon le contexte du produit, du lieu et des incentives prévues, cela peut fonctionner et permettre d’atteindre de nouveaux publics.

Enfin, des outils existent pour organiser et suivre des tests en ligne, à distance. L’intérêt d’utiliser ce type d’outils peut être double si votre produit est dématérialisé : toucher des personnes qui ne peuvent pas être présentes dans votre laboratoire ou que vous ne pouvez pas aller voir 👀 + toucher de nouvelles personnes si la plateforme en question propose également la mise en relation avec des utilisateurs potentiels. ⚠️ Attention alors à la solidité de votre scénario et à la fiabilité des résultats provenant d’un tel panel, qui est quasiment “professionnel” dans le secteur des tests utilisateurs (et donc potentiellement biaisé).

Combien de temps une session de test utilisateurs doit-elle durer ?

Il faut déjà se mettre en tête que le temps de vos testeurs est aussi précieux que le vôtre 🎁 : ils donnent de leur disponibilité et de leur personne pour vous aider et vous apporter des insights qui ont beaucoup de valeur… Ne gaspillez donc pas cette ressource et évitez de les faire attendre ou venir pour rien.

Concernant la durée du test à proprement parler, il se dit qu’un test de 60 à 90 minutes est idéal. ⏰ De mon point de vue, 60 minutes est déjà long pour un participant qui se concentre à la réalisation de ses tâches… J’essaie donc personnellement de faire rentrer la partie manipulation en 45 minutes, l’introduction et la conclusion en 20–30 minutes supplémentaires.

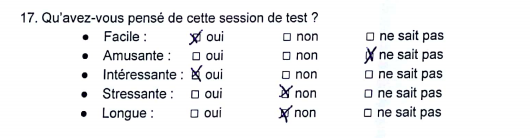

👉 Il peut être intéressant de poser la question de l’appréciation de la durée du test dans votre questionnaire post-test, afin de pouvoir l’ajuster en fonction, pour votre session de tests suivante.

Comment préparer un test utilisateurs ?

Le support de test

Posez-vous déjà la question du but que vous cherchez à atteindre avec ce test. En fonction, mettez au point le support de test qui vous permettra de l’atteindre. 💭 Vous voulez choisir entre deux scénarios de produits ? Des zonings suffisent largement. Vous voulez vérifier l’ergonomie d’un écran ? Un wireframe fera tout à fait l’affaire. Vous voulez valider l’attractivité d’un design ? C’est une maquette graphique qu’il vous faut. Vous voulez tester la fluidité d’un parcours ? Un prototype interactif sera idéal.

Le plan de test

Passez ensuite à votre plan de test. ✍️ Vous devez rédiger tout un scénario dans lequel vos participants s’immergeront pour réaliser toutes les tâches nécessaires au test de votre support. C’est, je trouve, la phase la plus délicate : chaque consigne que vous rédigerez doit respecter un équilibre précis ⚖️ :

- donner assez de contexte pour nourrir le participant, sans en donner trop pour ne pas risquer de le noyer dans des informations qu’il ne s’appropriera pas

💡 Par exemple : La phrase “Vous êtes à la recherche d’une nouvelle paire de chaussures qui vous permettra d’aller courir au moins 2 fois par semaine en forêt” suffit pour donner du contexte à votre testeur. Inutile d’inventer une vie précise à votre participant comme si c’était un persona que vous rédigiez. Au contraire, c’est la spécificité des attentes de votre testeur qui peut être intéressante à découvrir.

- donner assez de précisions dans la consigne pour que le participant ne soit pas perdu, sans pour autant guider strictement ses actions, ce qui créerait un gros biais dans le test

💡 Par exemple, préférez “Vous décidez d’acheter cette paire de chaussures” à “Cliquez sur le gros bouton bleu à droite pour ajouter la paire de chaussures au panier”.

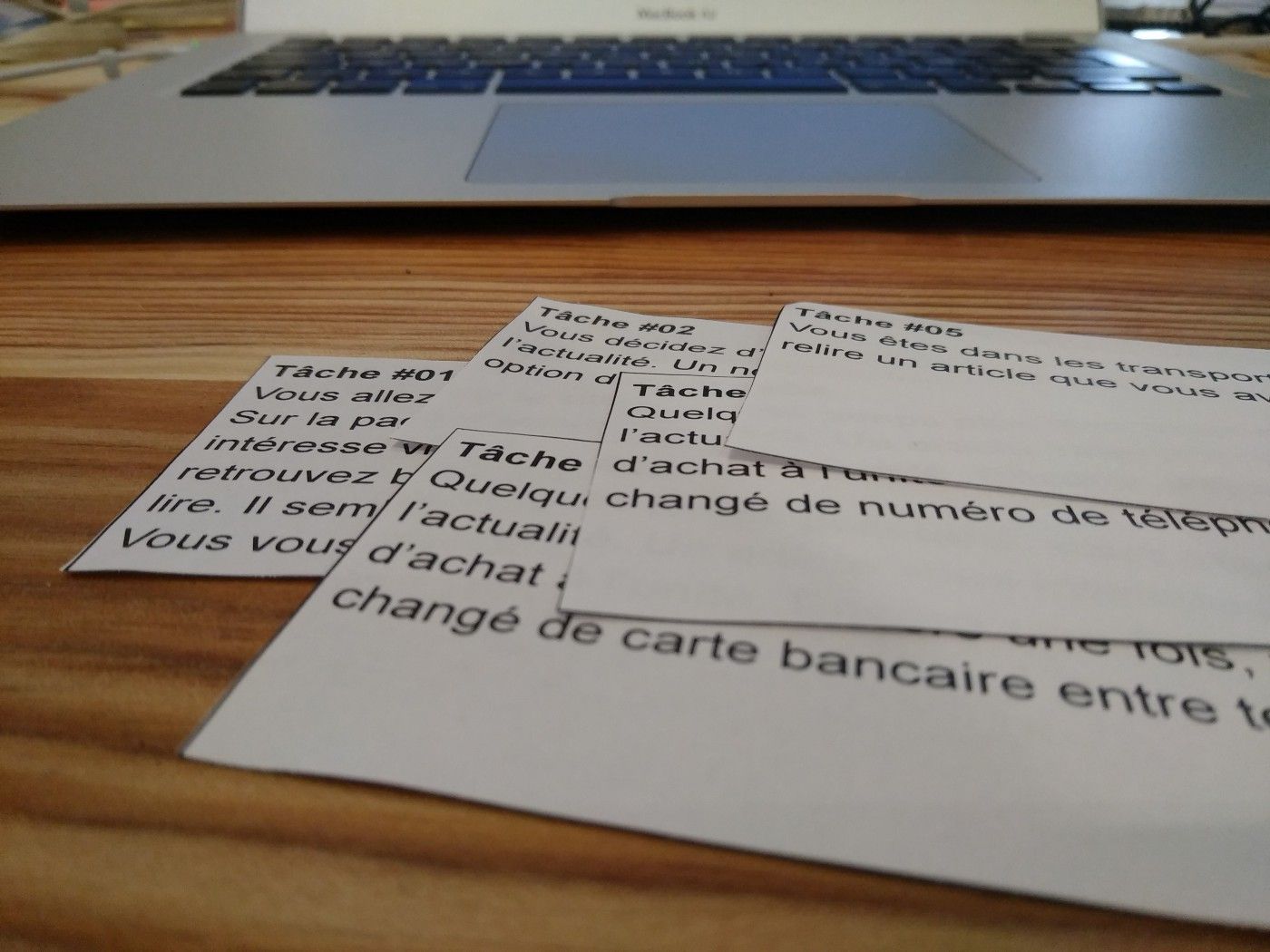

Numérotez chaque tâche et imprimez-la en gros sur une fiche dédiée. Faites en sorte que les tâches ne soient pas trop nombreuses. On en reparlera un peu plus bas.

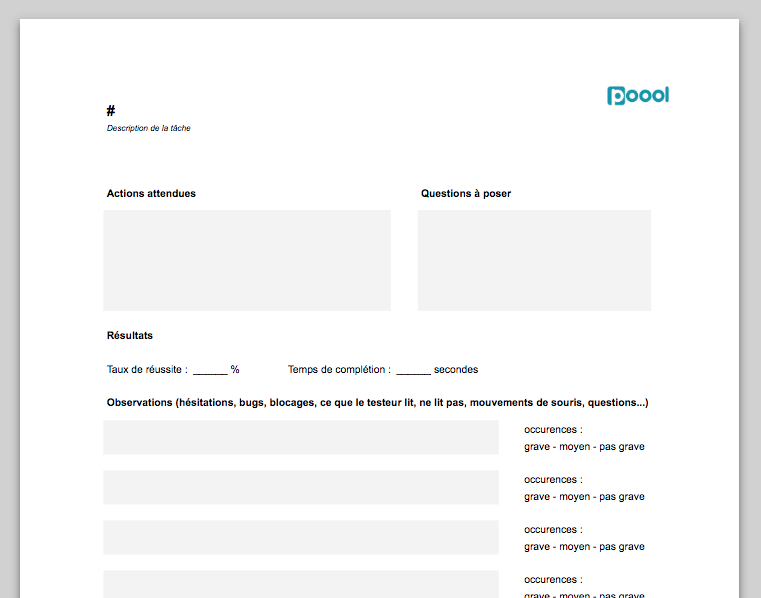

Les fiches d’observation

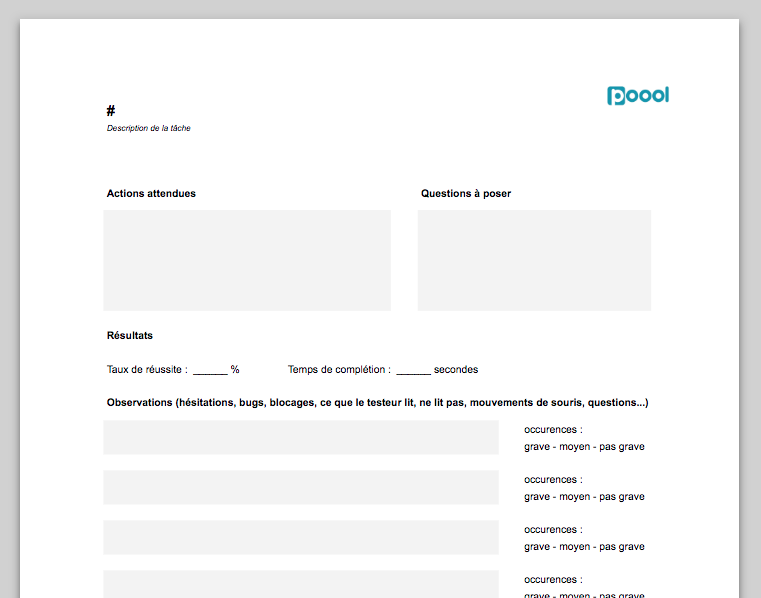

Vous devez ensuite préparer des fiches d’observation des tâches. 🔍 Pour chacune de vos consignes, créez un document qui vous permettra de suivre sa réalisation 📄 : notez-y le numéro et l’énoncé de la tâche, la suite des actions attendues et les questions à poser. Insérez-y des espaces libres dédiés à la saisie des résultats et des observations : taux de réussite (0, 50 ou 100%), temps de complétion (indicateur pas forcément pertinent en fonction de la tâche), occurence et gravité de toutes les observations…

Imprimez autant d’exemplaires de fiches d’observation que de tâches existantes.

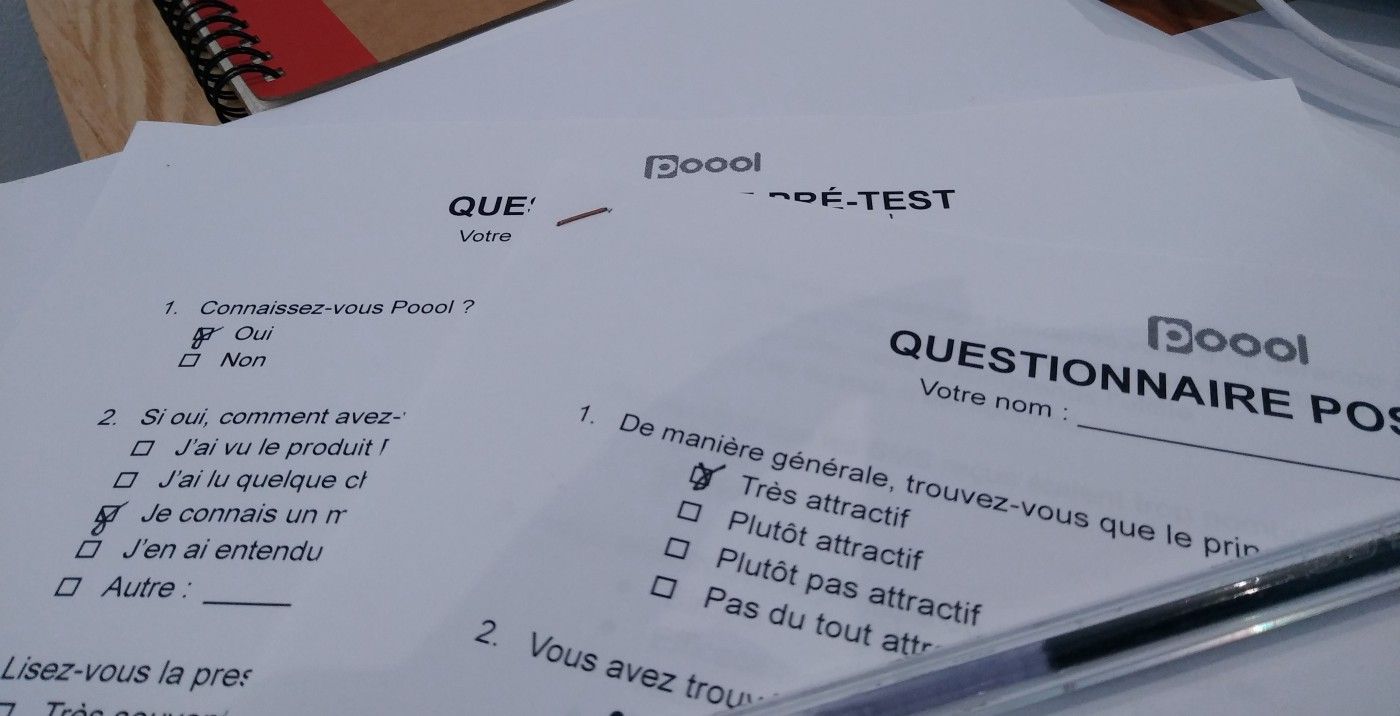

Les questionnaires pré-test et post-test

Préparez également vos questionnaires pré-test et post-test. Ces questionnaires sont très utiles.

☝️ Le questionnaire pré-test a d’après moi trois beaux avantages :

- faire patienter le participant s’il vous reste deux-trois réglages ou préparatifs à finaliser avant le début de la manipulation

- détendre le participant avec une première activité simple et rapide qui l’immerge doucement dans la session

- mieux qualifier le profil du participant par rapport au contexte du produit testé (par exemple, chez Poool, c’est le moment de demander à la personne si elle a l’habitude de lire la presse, de lire la presse en ligne, d’utiliser des outils numériques…).

☝️ Le questionnaire post-test, lui, permet de compléter l’observation de la manipulation en recueillant les impressions du participant. C’est le moment de le questionner sur ce qu’il a pensé de tel process, telle couleur, telle fonctionnalité. 💬 C’est souvent hyper marrant, parce qu’un participant peut avoir réellement peiné à réaliser une tâche mais ne pas avoir cette sensation dans la “notation” du questionnaire post-test, et inversement. Ce sont des éléments intéressants qui permettent de nuancer la gravité d’une friction et globalement la synthèse des résultats.

Cela peut aussi être l’occasion d’obtenir l’avis du participant sur des éléments “hors-test”, comme une variation de graphisme, d’autres pistes de recherche, ou comme je vous en ai parlé plus haut, le déroulé-même du test.

Le test du test 🙃

Non, ce n’est pas une blague ! Testez toujours votre test et chronométrez-le, car je vous promets que vous aurez forcément oublié quelque chose. Une personne sympathique de votre équipe acceptera gentiment de tester votre scénario avec vous. 🤗

👍 Cela permet d’ajuster la durée du test, éventuellement le nombre de tâches demandées, de corriger des énoncés de tâches ou des réponses de questionnaires peu clairs, de re-paramétrer le support de test, de se mettre bien en tête des moments-clés où vous devez intervenir lors de la manipulation…

Le lieu et le matériel de test

Là, tout est possible. L’idéal est de profiter pleinement de l’environnement du testeur : son lieu de vie ou de travail par exemple et ses devices. Ainsi, il se sent en confiance et peut réaliser les tâches exactement comme il le ferait tout seul. De plus, l’utilisation de son matériel vous permet de découvrir des cas que vous n’auriez peut-être pas vus dans vos locaux : “Ah tiens, avec les vieux smartphones, ça donne ça. Ah tiens, sur Edge, ça donne ça.” 😉

Mais on sait qu’il n’est pas toujours possible ou pratique, pour nous comme pour les testeurs, de réaliser le test dans l’environnement de ces derniers. Vous pouvez alors les accueillir dans vos locaux ou dans un lieu loué pour l’occasion et aménagé en “laboratoire” pratique pour observer les manipulations. 💻 Dans tous les cas, vous devez prévoir du matériel de backup pour réaliser le test en toute situation.

La question du matériel ne concerne pas que le matériel informatique. Prévoyez également des feuilles, des stylos et tous les supports complémentaires nécessaires à la bonne réalisation de votre scénario. Dans le cadre de sessions de tests, il m’est arrivé d’imprimer des faux SMS de confirmation sur des maquettes de smartphone ou de faire cartonner de fausses CB. Ces petits détails rendent le test beaucoup plus fluide.

Comment un test utilisateurs se déroule-t-il ?

Inviter votre participant

Une fois que votre participant s’est porté volontaire pour la session de test, il faut trouver un créneau de disponibilité. C’est le premier échange personnel que vous aurez avec votre testeur alors instaurez une relation simple et chaleureuse. Remerciez-le pour son aide et ne lui dévoilez pas l’objet du test, même si vous pouvez au moins communiquer son enjeu. Par exemple, pour ne pas créer de biais, ne dites pas “Il s’agit de tester notre nouvelle application innovante de mise en relation professionnelle” mais “Votre participation va beaucoup nous aider à améliorer notre prochain produit digital”. Rassurez-le sur la durée du test et encouragez-le à ne pas rechercher plus d’informations sur votre société ou vos produits avant le jour J.

Accueillir votre participant

L’expérience testeur a déjà débuté lorsque votre participant arrive (ou que vous arrivez chez votre participant). Ne le faites pas attendre et installez-le confortablement pour remplir son questionnaire pré-test. N’hésitez pas à proposer une boisson fraîche, une boisson chaude et/ou une collation.

J’avais lu quelque part un bon conseil qui disait de les mettre bien en évidence car souvent, les testeurs n’osent pas accepter la simple invitation à boire ou manger.

Introduire la session de test

Une fois le questionnaire pré-test rempli, je vous conseille de présenter l’objectif de la session et le déroulé de la manipulation. Globalement, voici ce que vous pouvez dire ou rappeler, dans l’ordre que vous souhaitez :

- “Encore merci” 😜

- “Il y aura 3 phases : le questionnaire pré-test déjà rempli, la manipulation et le questionnaire pré-test”

- “Cela va durer 60 minutes environ”

- “Il y aura un ensemble de tâches à réaliser, les unes après les autres : l’idée est de voir si elles sont faciles à réaliser ou pas et comment on peut améliorer cela”

- “On ne va pas vous aider à réaliser ces tâches et on ne va ni intervenir, ni réagir, ni répondre à vos questions pendant la manipulation. Par contre on en discute sans souci dès le test terminé !”

- “On va noter plein de choses, et c’est normal.”

- “Ce n’est qu’un test, rien n’est enregistré ou réellement pris en compte, que ce soit une inscription, une commande, un paiement, ou autre.”

- “C’est notre solution qu’on teste, pas vous”

- “Il faut absolument être sincère, on ne va rien prendre mal. Vos retours vont nous aider dans tous les cas.”

- “Il n’y a pas de bonnes ou de mauvaises réponses”

👉 Tous ces propos ont pour but de rassurer le testeur, qui, même s’il ne vous le dit pas, est certainement un peu anxieux de bien faire.

Observer la réalisation des tâches

Je vous conseille vivement d’observer la réalisation des tâches à deux. 👥 C’est beaucoup plus complet et facile. Par exemple, une des deux personnes va pouvoir se consacrer à l’animation du test et à l’avancée du scénario sur le produit pendant que l’autre va pouvoir se concentrer sur l’observation du participant, de ses réactions verbales et non verbales. Être deux permet également d’écarter les erreurs d’interprétation au moment de l’analyse des résultats.

Deux conseils pour cette phase d’observation :

- 🤓 préserver l’attitude neutre et externe de l’observateur : vous deviendrez un·e champion·ne du “mmh mmh”, “ok”, “d’accord” vague mais encourageant.

- ✍️ tout noter sur vos fidèles fiches d’observation : blocages, hésitations, questions, émotions positives comme négatives, commentaires, mouvements… ainsi que les critères quantitatifs comme le taux de réussite ou le temps passé sur la tâche si cette métrique est pertinente pour votre projet.

Par retour d’expérience, je trouve qu’il est assez difficile de tout noter sans dégrader la fluidité de l’échange avec le participant. Il faut donc trouver le bon équilibre avec le temps. Une piste réside dans l’enregistrement audio ou vidéo de la session, avec capture de la manipulation sur l’écran 📹 (et avec consentement préalable bien sûr), mais encore faudra-t-il avoir le temps de dé-rusher toutes les ressources multimédia ainsi générées.

Remercier votre participant

Une fois la manipulation terminée, le questionnaire post-test rempli et la discussion terminée autour des interrogations et remarques du participant, il est temps de clôturer la session de test. ⌛

Se pose souvent la question de l’incentive testeur : doit-on le rémunérer, lui offrir un cadeau ? Et bien… à vous de voir. Si vous avez les moyens de rémunérer votre testeur, vous êtes chanceux, mais attention alors à ce que le testeur ne soit pas venu que par intérêt et que sa rémunération n’ait pas influencé ses réponses. Si vous ne pouvez pas le rémunérer, peut-être avez-vous un petit budget cadeau qui lui fera certainement plaisir ? 🎁 Là encore, le danger est de tomber dans le piège du goodie inutile et créateur de déchets alors à vos réflexions pour une attention personnalisée et dématérialisée !

Sinon, pas d’inquiétude, vos remerciements et votre reconnaissance éternelle suffiront certainement à votre testeur volontaire, d’abord venu par extrême gentillesse suite à votre appel. 💝

Comment analyser les résultats d’un test utilisateurs ?

Là encore, je pense qu’il n’y a pas de manière universelle pour traiter les résultats de votre test utilisateurs. Tout dépend de la complexité des tâches à réaliser, de leurs critères de succès identifiés et également du nombre de testeurs impliqués. 🤔 Difficile et dangereux d’adopter une démarche statistique sur un petit échantillon de 5 personnes…

Dans une approche un peu plus qualitative que quantitative, avec laquelle je suis personnellement plus à l’aise, voici la démarche que je peux vous conseiller de mettre en place.

Listez d’abord tous les retours sans exception. Associez-y leur gravité et le nombre d’occurrences. Vous serez alors capables de les classer par priorité de traitement. ✏️ En gestion de projets, il y a une notion intéressante qui est l’évaluation du risque. Mes cours sont loin mais je me souviens de la formule R = P x G, où R représente le caractère critique du risque, P sa probabilité et G sa gravité. C’est une formule qui s’applique assez bien à la priorisation des optimisations à réaliser. Finalement, ce n’est que du bon sens 🙂

N’oubliez pas de mettre en relation les retours que vous avez récoltés avec les profils qualifiés de vos testeurs, pour pouvoir nuancer les résultats au besoin. Discutez avec votre binôme pour vous assurer que vous avez la même vision de ces résultats. 👥

Comment partager la conclusion des résultats du test utilisateurs ?

Finalement, la communication des résultats est le point-clé de la démarche de test utilisateurs. 📣 À quoi bon investir toute cette énergie si les données ne sont pas communiquées à l’équipe pour les transformer en “pour action” salvateurs ?

Vous l’aurez compris, les résultats peuvent être un ensemble de retours qualitatifs et quantitatifs. Les présenter à l’équipe vous permet d’intégrer l’ensemble des collègues concernés à la démarche d’optimisation, de prendre ensemble un peu de recul sur le produit et de sensibiliser l’équipe à la notion d’empathie utilisateurs. 🧗

Concrètement, vous avez à ce moment-là une liste de retours, classés par priorité de traitement.

- Commencez par exprimer les retours positifs. Ils sont nombreux, ils sont importants, ils doivent être partagés.

- Ensuite, communiquez les points bloquants, qu’il faut absolument résoudre pour la viabilité du projet.

- Partagez ensuite les feedbacks moins critiques, les points d’amélioration réels dont il faut se souvenir et qu’il faut surveiller, mais qui ne menacent pas directement le projet.

- Enfin, vous pouvez énoncer tous les retours “neutres” si vous le souhaitez, ceux qui n’appellent pas à l’action car pas assez communs, trop spécifiques, pas forcément négatifs…

Pour communiquer tous ces éléments, l’utilisation d’un code couleurs peut être intéressante. 📗 Vert, 📙 orange, 📕 rouge : c’est simple à décrypter, et c’est psychologiquement plus agréable de voir que des retours rouges cohabitent tout de même avec des retours verts.

Le partage des résultats n’est pas une leçon de morale : l’équipe est là pour les découvrir, les prendre en compte et au final trouver des solutions, ensemble. C’est là que la démarche scientifique du test a toute son importance : n’oubliez pas d’expliquer le processus strict des tests, d’illustrer vos retours par des captures, des citations, des statistiques… L’équipe doit comprendre que ce ne sont pas vos retours, mais ceux des utilisateurs.

Le test utilisateurs… et après ?

Après votre test utilisateurs, je ne saurais que vous conseiller d’optimiser votre solution… et de la tester à nouveau ! 🎉

Vous l’aurez compris, pour organiser un test utilisateurs pertinent, efficace et agréable, il faut apprendre et respecter un ensemble de bonnes pratiques. Mais d’après moi, ce sont surtout une compétence et des réflexes à développer de manière empirique. Alors n’hésitez plus, lancez-vous ! 🏃

Si les tests utilisateurs vous intéressent, je vous conseille chaudement la certification “Conducting usability testing” de l’Interaction Design Foundation qui permet de vous y former de manière très qualitative !

Cet organisme propose des formations professionnelles et complètes sur de nombreux sujets de design UX.

Contenu publié initialement par Yuna Orsini sur notre ancienne plateforme Medium "Poool Stories"